Les données concurrentielles sur le marché de la location de courte durée offrent aux gestionnaires des réponses à des questions importantes concernant leur stratégie tarifaire. Ce type de données est également utilisé dans la gestion des revenus et les algorithmes de tarification pour optimiser le prix. Pour que les données soient prédictives, elles doivent être à la fois précises et représentatives. Sélectionner les bonnes données qui remplissent ces deux conditions peut être un véritable défi.

Dans cet article, nous examinerons les deux sources les plus courantes de données concurrentielles (données collectées via scraping vs. données d’hôtes anonymisées), explorerons leurs limites, puis expliquerons quand les utiliser en combinaison avec vos propres données.

Données de marché et de concurrents : scraping vs. données d’hôtes anonymisées

Données issues du scraping

Le terme « scraping » vient de « screen scrape ». À l’origine, il s’agissait de programmes qui visitaient des sites web et extrayaient les données affichées à l’écran. Bien que certaines méthodes se soient perfectionnées, le principe d’extraire des données d’internet reste le même. Les données sont récoltées en visitant le site web d’une entreprise et en extrayant les informations qui vous intéressent.

Avant que les développeurs ne créent des programmes pour collecter ces données à grande échelle, les analystes et gestionnaires recueillaient les données en naviguant manuellement sur ces sites. Ce processus est extrêmement chronophage, selon la quantité d’informations à capturer. De nombreux propriétaires et gestionnaires continuent à consulter manuellement ces sites pour vérifier les prix.

Dans notre secteur, les gestionnaires s’intéressent fortement à ce que facturent leurs concurrents proches, à leur taux d’occupation, et à la comparaison avec leur propre activité. Le scraping des données des OTA constitue une méthode fiable pour collecter en masse les données des concurrents et commencer à répondre à ces questions. La grande majorité des données utilisées sur le marché de la location de courte durée sont recueillies de cette façon.

Données d’hôtes anonymisées

Les données issues du scraping proviennent de l’accès à l’interface frontale d’une application ou d’un site web. En revanche, les données d’hôte proviennent du gestionnaire, du propriétaire ou de l’hôte du bien. En tant que gestionnaire ou propriétaire, vous pouvez accéder à ces données pour l’ensemble de vos logements. Mais vos chiffres ne vous offrent pas l’éclairage que vous cherchez sur vos concurrents.

Dans l’industrie hôtelière, plusieurs prestataires vendent ces données d’hôtes sur le marché. Ces données proviennent d’autres hôtes de votre secteur. L’arrangement avec les acheteurs de ces données est qu’ils en sont également des fournisseurs. Pour accéder aux données d’autres propriétés, ils doivent eux-mêmes contribuer à la base collective. Ensuite, les données sont agrégées, ce qui préserve l’anonymat des autres hôtes.

Précision et limites des données concurrentielles

Le but des données concurrentielles est d’aider les gestionnaires à mieux comprendre leur marché et leurs concurrents. Cette meilleure compréhension leur permet de faire de meilleurs choix concernant leur stratégie tarifaire et la durée minimale de séjour, ce qui conduit à de meilleurs revenus par unité.

Données issues du scraping

Les données récupérées via le scraping ont leur utilité comme source, mais elles constituent tout simplement le type de données le moins fiable et le moins précis disponible. Ce n’est pas particulièrement surprenant quand on pense à leur mode de collecte. Une manière bien plus simple d’obtenir les mêmes données consisterait à demander à Airbnb ou VRBO l’accès à leurs API, éliminant ainsi la nécessité d’interroger sans cesse leur front-end pour obtenir des informations.

De nombreuses raisons rendent cela improbable, donc le seul moyen d’obtenir les données reste de générer d’innombrables requêtes vers leur site, puis d’interpréter les réponses. Sur les marchés dynamiques, les prix évoluent fréquemment. Les biens gérés professionnellement peuvent voir leur prix changer plusieurs fois par jour. Cela représente un défi de taille pour le scraping, car faire tourner le programme de collecte à très haute fréquence et stocker autant de données devient vite très coûteux. Si la fréquence du scraping est trop basse, on manquera les changements importants.

Pour vous donner une idée de l’échelle, gérer les données de tarification quotidienne d’une seule unité sur les 365 prochains jours, tout au long d’une année, peut prendre jusqu’à environ 20 Mo, en supposant une mise à jour une fois par jour. Cela représente un bloc moyen de 1 Go pour 50 unités suivies sur un an. Gardez à l’esprit qu’une ville moyenne peut compter de 2 000 à 5 000 unités, et les grandes agglomérations entre 20 000 et 30 000+ unités. Il faut aussi tenir compte des nouveaux biens, de ceux qui sont re-listés, et de ceux qui sont retirés du marché.

L’occupation peut aussi être difficile à calculer précisément à partir du scraping. Les scrapers ne voient qu’une valeur binaire d’occupation « occupé » ou « non occupé », mais il existe une troisième valeur qu’ils ne perçoivent pas : « occupé par le propriétaire ». Certains segments d’inventaire sont aussi bloqués par le gestionnaire pour diverses raisons. Ainsi, l’inventaire peut sembler réservé alors que le gestionnaire le garde juste temporairement hors marché.

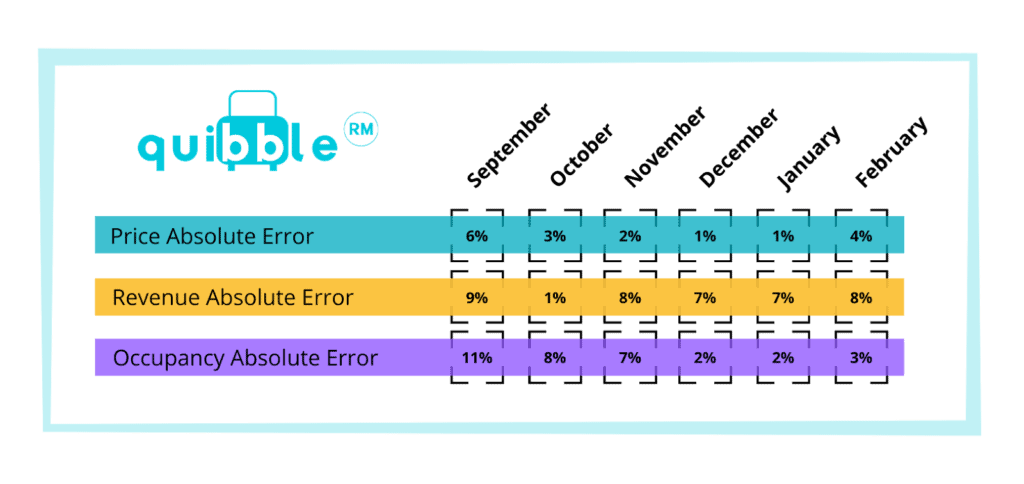

De même, certaines propriétés apparaîtront comme réservées ou annulées. La combinaison des imprécisions sur les prix et sur l’occupation fait qu’il est difficile de calculer précisément le revenu. Quibble a utilisé un scraper sur un ensemble de propriétés pour lesquelles nous avions aussi les données d’hôtes. L’expérience a duré six mois sur 100 propriétés aux États-Unis. Voici les résultats :

Le but de cette expérience était de tester la précision des données et leur intérêt pour leur intégration dans notre algorithme de tarification. L’erreur est la différence entre ce que le scraper a capturé et les véritables données d’hôtes. Cette marge d’erreur est-elle significative ? Cela dépend de l’objectif et de la finalité de ces données.

Données d’hôtes anonymisées

Les données d’hôtes sont très fiables car la source est l’hôte lui-même. Elles ne souffrent pas d’imprécision sur les prix, l’occupation ou le revenu. L’hôte réalise chaque réservation et en connaît donc le prix exact. Il connaît ainsi le revenu et le taux d’occupation, puisqu’il contrôle la disponibilité de l’inventaire.

La principale contrainte des données d’hôtes concerne leur disponibilité. Très peu de fournisseurs proposent actuellement ces données à l’industrie de la location de courte durée. Le fournisseur le plus notable est Key Data Dashboard. Pour récolter ces données, le fournisseur doit établir une relation avec de nombreux gestionnaires d’un même secteur. Si une zone ne compte que 2-3 gestionnaires ou très peu de biens, les données anonymisées perdent leur intérêt et l’anonymat est compromis. Cependant, dès que le marché compte suffisamment de participants, les données deviennent extrêmement utiles et fiables.

Quelle est la valeur de ces données ? Elle dépend du niveau de pénétration du fournisseur sur votre marché.

Quand et comment utiliser chaque source de données concurrentielles dans la location de courte durée

L’un des avantages majeurs des données issues du scraping réside dans la rapidité de leur production sans devoir établir des centaines ou milliers d’accords réciproques. Ainsi, les scraping tools et les vendeurs peuvent récupérer des données sur des centaines de milliers de propriétés en très peu de temps. Ce que ces données perdent en précision, elles le compensent en quantité. À l’inverse, les données issues des hôtes anonymisés sont en quantité plus limitée mais sont bien plus précises.

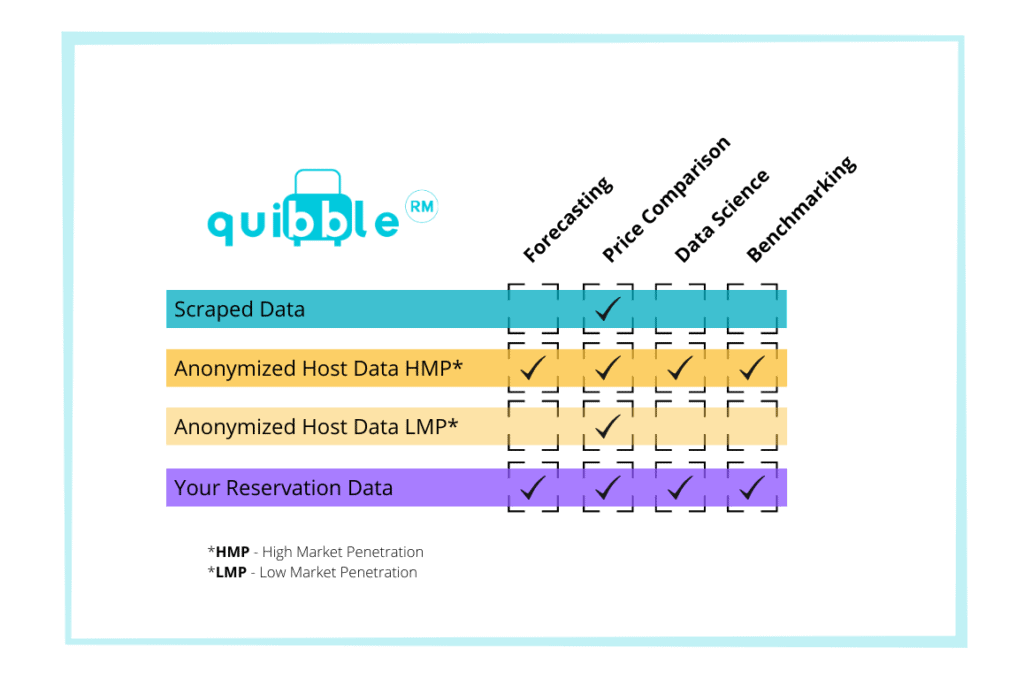

Le tableau ci-dessous décrit l’usage approprié de chaque type de données disponible.

Comme les données issues du scraping présentent la plus grande marge d’erreur, elles ont le moins de fonctions dans votre boîte à outils. Un bon scraper tournant de façon fréquente devrait offrir la plus faible erreur sur la capture des prix des concurrents. Ces données sont donc excellentes pour la comparaison de prix.

Toutes les fonctions de tarification et de gestion des revenus de votre entreprise peuvent utiliser les données anonymisées dans un marché à forte pénétration (+10% du marché représenté). Si la pénétration est faible, il faut traiter ces données comme les données issues du scraping.

La source de données dont vous devez être 100 % sûr est celle de vos propres réservations. Elle est idéale pour l’ensemble des fonctions de votre activité.

Conclusion

Toutes les sources de données concurrentielles n’ont pas la même valeur prédictive, selon leur précision et leur représentativité du marché global. Cela signifie qu’elles joueront différents rôles dans votre entreprise et vos fonctions de gestion tarifaire et de revenu. Utiliser la bonne donnée au bon moment peut améliorer votre prise de décision et vos résultats financiers.

Uvika Wahi est rédactrice chez RSU by PriceLabs, où elle dirige la couverture de l’actualité et l’analyse destinées aux gestionnaires professionnels de locations saisonnières. Elle écrit sur Airbnb, Booking.com, Vrbo, la réglementation et les tendances du secteur, aidant les gestionnaires à prendre des décisions éclairées. Uvika intervient également lors d’événements internationaux majeurs tels que SCALE, VITUR et le Direct Booking Success Summit.